Google opère des changements constants dans ses algorithmes. La plupart des bonnes pratiques pour que les pages d’un site web soient indexées et bien positionnées en référencement naturel sont connues de longue date, à commencer par l’unicité et la qualité des contenus mis en ligne. D’autres sont plus récentes et liées à des modifications ces dernières années des mécanismes de fonctionnement de Google, notamment en matière de fréquence d’indexation et de priorisation des pages à indexer.

Réduction de la fréquence d’indexation et priorisation des pages à indexer

Ces dernières années, compte-tenu du nombre exponentiel de sites internet à explorer (crawler, en anglais), Google a réduit sa fréquence d’indexation afin de diminuer les coûts et l’empreinte carbone associés à la mise à jour de son index. Ce qui a un impact sur le temps nécessaire pour indexer de nouvelles pages et déterminer leur position, ainsi que sur la prise en compte des mises à jour des contenus des pages et des articles déjà référencés par le moteur de recherche.

Google a changé ses règles de crawl. Le moteur de recherche utilise l’intelligence artificielle pour prédire à quelle fréquence de nouveaux contenus sont publiés sur les sites web. Avec l’arrivée du predictive crawling (en français, crawl prédictif), les robots d’indexation de Google ne passent plus (forcément) aussi souvent : ils le font en fonction de la fréquence des mises à jour des sites.

Google utilise deux robots distincts, le Deep crawl bot et le Fresh crawl bot, pour explorer et indexer les contenus en ligne. Le Deep crawl bot se rend sur les sites web environ une fois par mois et analyse tous leurs contenus (pages, articles, images, PDF…) afin de réaliser un rafraichissement complet de son index. Le Fresh crawl bot visite quant à lui plus fréquemment les sites. C’est lui qui repère et indexe rapidement les articles d’actualité. Pour les autres contenus, il ne scanne que les pages déjà considérées comme les plus importantes d’un site et celles qui sont fréquemment mises à jour.

Google a par ailleurs adopté une approche de priorisation lors de l’indexation de nouveaux contenus web. Certaines pages peuvent être détectées mais indexées ultérieurement si le moteur de recherche considère qu’elles ne sont pas prioritaires (dans ce cas, le message suivant apparaîtra dans la Google Search Console : page « Détectée, actuellement non indexée »). Ce qui rend encore plus cruciale la production de contenus de qualité et à valeur ajoutée dès la mise en ligne de nouvelles pages ou articles, afin de maximiser les chances qu’elles/ils soient considéré(e)s comme devant être indexé(e)s rapidement par Google.

Que faire pour accélérer l’indexation de nouvelles pages par Google ?

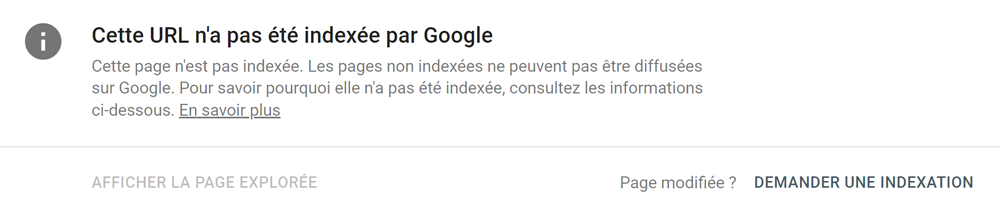

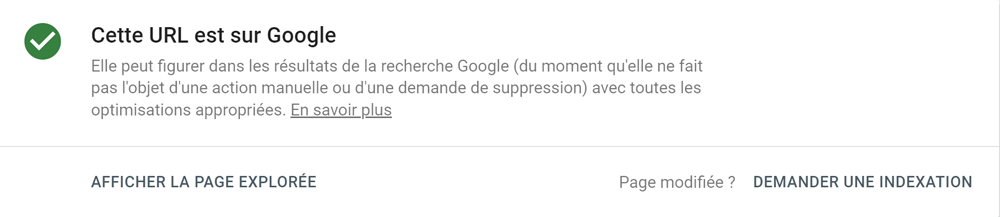

Lorsqu’une page ne remonte pas dans les résultats de recherche, il est recommandé d’utiliser l’outil d’inspection des URL de la Google Search Console pour vérifier si la page est indexée ou non, et de détecter d’éventuels problèmes.

Google Search Console – URL non indexée

Google Search Console – URL indexée

Depuis que Google a mis en place son crawling prédictif, deux bonnes pratiques pour faire indexer rapidement une URL sont de s’assurer de la qualité du contenu publié (pas de duplicate content, contenu original et à valeur ajoutée) puis de faire comprendre aux algorithmes du moteur de recherche que votre nouveau contenu est important. Ce qui implique de travailler le maillage interne de votre nouvelle page (en plus des balises titre, h1, h2, noms des images, etc.) pour aider Google à trouver son contenu (qui pointe vers d’autres contenus importants de votre site), à l’indexer et à le positionner dans ses résultats.

Quid du rythme de publication de nouveaux contenus pour améliorer le référencement naturel ?

Les robots de Google explorent plus fréquemment les sites qui publient souvent de nouveaux contenus et qui sont régulièrement mis à jour. Pour améliorer les chances d’indexation et de bon référencement, il est donc essentiel de proposer régulièrement de nouveaux contenus uniques et utiles pour vos cibles de communication. Cependant, la fréquence de publication ne doit jamais se faire au détriment de la qualité des contenus. Il est à noter qu’un site jugé de confiance par le moteur de recherche peut très bien bénéficier d’une indexation rapide de ses nouveaux contenus.

Lire aussi :

Référencement naturel : comprendre l’importance du budget crawl

Rédiger des contenus efficaces pour le web

Vous avez besoin d’un accompagnement pour améliorer le référencement naturel de votre site internet ? Contactez-nous !